Pero, ¿realmente el Crawl Budget tiene tanta relevancia en el posicionamiento de una web?

¿Qué es el Crawl Budget o Presupuesto de Rastreo?

El Crawl Budget o Presupuesto de Rastreo es el tiempo o número de solicitudes que nos da Google para revisar el contenido de nuestro sitio web.Esto lo hace a través de un crawler llamado GoogleBot, el cual se pasea por el sitio con un periodo limitado para analizar una página web.

En web grandes (+100.000 URL) suele tenerse bastante en cuenta, sobre todo si el sitio web es bastante actualizado y Google se queda bastante corto al rastrear nuestro site.

¿Por qué es tan importante el Crawl Budget?

La importancia del crawl budget varía bastante en función de las necesidades de cada web, pero conforme más grande sea tu web más importancia tendrá esta varible.Imagina que tienes una página web de 1 millón de URL, pero Google al cabo de 3 meses solo rastrea 1.000 URL distintas. En este caso tendremos un problema relacionado con el Crawling de nuestra web.

La primera pregunta para saber la importancia de presupuesto de rastreo en nuestra web sería ¿por qué quieres que Google visite tu web o una URL?

Si Google no puede ver nuestras URL, no podrá indexarlas y al no indexarlas no obtendremos tráfico orgánico.

Y la segunda pregunta ¿Cada cuento tiempo debería Google visitar una URL en concreto?

Depende, imagina una URL que no actualizas en 1 año ¿por qué Google debería visitarla todos los días si la URL no varía?

En cambio, imagina una URL que actualizas todos los días, sería normal que Google la visitase todos los días, ¿no?

Aquí está la respuesta a la pregunta de si es importante o no el presupuesto de rastreo.

¿Qué presupuesto de rastreo asigna Google a nuestra web?

El crawl budget que asigna Google a nuestra web casi siempre es inferior al número de URL que forman nuestro site, pero esto a priori no debería ser un problema.Debido a que muchas variables como las URL NOINDEX, URL que no reciben tráfico, etc puede hacer que Google pasen cada muy poco tiempo por dichas URL.

Aunque en la mayoría de casos, el crawl budget que asigna Google a nuestra Web es suficiente para rastrear las URL más importantes.

Este presupuesto de rastreo se puede dividir en varios grupos por tipología de URL:

URL status code 200

URL status code 301

URL status code 400

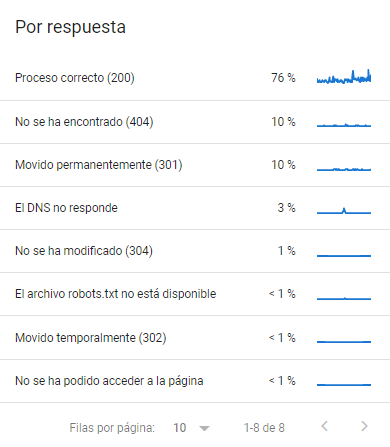

En una web con bastante recorrido en el que las URL cambian en el tiempo, es normal que nuestro crawl budget no se enfoque solamente en URL con status code 200. En la mayoría de casos estas URL reciben el 75% del presupuesto, repartiendose el resto en URL con otro status code.

Cómo aumentar el Crawl budget de nuestra web

No existe una fórmula de éxito para aumentar nuestro presupuesto de rastreo, pero hay varias herramientas que pueden ayudar.Entiende que los siguientes puntos no debes analizarlos por separado, sino en conjunto, ya que una web con mucha velocidad, pero un alto nivel de thin content dará como resultado un bajo nivel de rastreo.

Y una web con una alta actualización o activación del Freshness obtienen una mayor nivel de rastreo que otras con mayor autoridad y velocidad.

Velocidad Web

Por velocidad web no me refiero a que tu saque un 100 en PageSpeed o tener una buena puntuación en Core Web Vital, sino que el tiempo de carga completo de un contenido en una URL sea lo más bajo posible.Cuanto más tiempo se entretenga Google Bot en una URL menos tiempo podrá dedicar a rastrear otras URL.

Robots.txt

El mayor aliado a la hora de optimizar el rastreo de una web es el archivo robots.txt, con él podremos guiar a Google Bot hacia las zonas más importantes de nuestra web y hacer que se olvide de aquellas zonas irrelevantes.Es importante que recuerdes que no es lo mismo el crawl budget que el pagerank, es decir, si bloqueamos una URL por robots.txt para que Google no acceda a distintas URL conseguiremos ahorrar presupuesto de rastreo, pero si esas URL están enlazadas consumirán PageRank.

Thin Content

En mi opinión el mayor enemigo que tiene el crawl budget es el Thin Content, ya que cuando Google encuentra una URL que no recibe tráfico orgánico (aun estando enlazado desde un nivel cercano a 0 de la arquitectura web) rastreará en menor medida esa URL, independientemente si está en INDEX o NOINDEX.Por ello, la optimización seo on page de una URL es básicas, sobre todo cuando nuestra web no tiene suficiente autoridad o en menor medida que nuestra competencia.

Códigos respuesta

Como has visto antes no todo el presupuesto de rastreo está enfocado a los Status Code 200, aun si no tenemos URL enlazadas internamente con Status Code distintos es habitual que Google rastree URL que un día rastreo y hoy ya no existen, de ahí los status code 3xx o 4xx.Aun así intenta no enlazar internamente URL con status code distintos a 200.

URL NOINDEX

Las URL NOINDEX suelen obtener un menor rastreo que las URL en INDEX, esto es debido a que tiene un menor valor a nivel de captación de tráfico.Autoridad web

La autoridad de nuestra web influirá en el rastreo que destina a la misma, algo que tiene todo el sentido.Si nuestra web tiene poca autoridad, captará un menor tráfico orgánico y como consecuencia el rastreo deberá ser menor que el de una web con mayor autoridad.

Actualización del contenido.

Quitando el robots.txt estaríamos en el punto más importante para aumentar nuestro crawl budget.En web a las que he podido tener acceso como periódicos o revistas que actualizan el contenido de la home, categorías, artículos relacionados, etc. Obtenían un presupuesto muy superior a otro tipo de web con una menor actualización.

Por otro lado, web estáticas con casi ninguna actualización recibían un menor rastreo, aun teniendo una autoridad mayor.

¿Cómo puedo saber las páginas que visita Google?

Saber cuáles son las páginas que Google Bot antepone en su rastreo, te vendrá muy bien para ponerte manos a la obra y optimizar/priorizar de acuerdo a tus necesidades SEO.Recuerda que no todos los sitios se les debe dedicar parte del presupuesto de rastreo por razones de relevancia.

Por ejemplo, no tiene sentido que se consideren las páginas de política de privacidad, cookies, o las clásicas paginaciones (2,3,4,5).

La mejor forma de analizar el crawling real de nuestra web es analizando los logs del servidor o con la herramienta de Log Analyzer de Screaming Frog.

Luego de un análisis, podrás contemplar las páginas por las que circula Google Bot y las que no, las que tienen mayor rastreo, la frecuencia del rastreo, si hay códigos 3xx, 4xx o 5xx a solucionar, y mucho más.

Conclusión sobre el Crawl Budget

Como puedes ver el presupuesto de rastreo puede variar bastante en función del tipo de web que analicemos, pero no será un valor determinante a la hora de posicionar en el 80% de las web, o que por lo menos no debería serlo si no tenemos un problema.En el caso de que Google no rastree nuestro sitio web o alguna en concreto URL en meses te recomiendo que apliques algunos de los consejos que comenté anteriormente.

Y recuerda que Crawl Budget no es igual a PageRank o autoridad web.